L’Europe régule l’intelligence artificielle. Ce texte classifie des solutions IA et impose des obligations selon les niveaux. Le Règlement Européen sur l’Intelligence Artificielle ( RIA) établit des structures de gouvernance aux niveaux européen et national, avec des autorités compétentes chargées de la surveillance du marché et de l’application des règles. L’objectif principal est d’encadrer l’IA de manière éthique et responsable, tout en favorisant l’innovation et la compétitivité de l’UE. L’entrée en vigueur du RIA se fera de manière échelonnée à partir de février 2025.

L’Europe régule l’intelligence artificielle

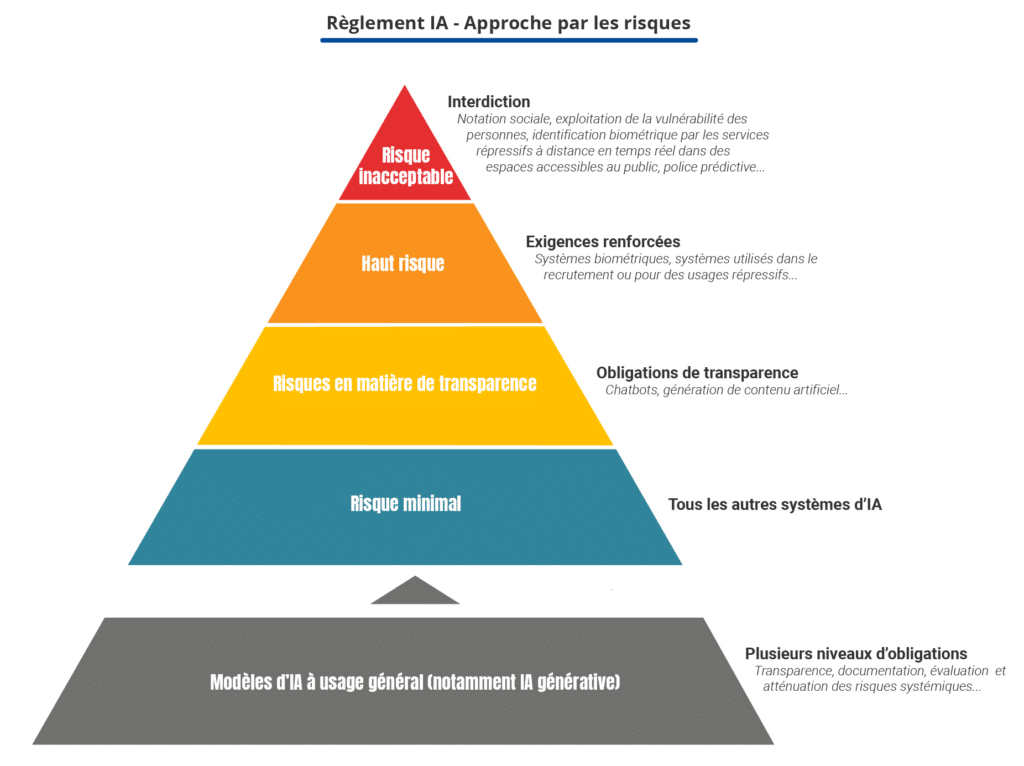

Trois niveaux de risques sont définis.

- Inacceptable : Exemples : la notation sociale, l’exploitation de la vulnérabilité des personnes, le recours à des techniques subliminales, l’utilisation par les services répressifs de l’identification biométrique à distance en temps réel dans des espaces accessibles au public, la police prédictive ciblant les individus, reconnaissance des émotions sur le lieu de travail et dans les établissements d’enseignement.. Ces IA sont interdites (sauf… et on verra les sauf.)

- Haut risque : Les plus réglementés. Exemples : systèmes biométriques, des systèmes utilisés dans le recrutement, ou pour des usages répressifs.

- Risque limité : Obligation d’information et de transparence, (chatbots, deepfake),

- Risque minimal : non règlementé, (jeux vidéo, filtres anti spam)

L’Europe régule l’intelligence artificielle

Après cette introduction, on peut se demander pourquoi ce texte alors que les USA et la Chine qui sont bien plus en avancé n’ont pas de régulation et surtout mettent en œuvre des niveaux IA qui sont inacceptables en Europe.

L’Europe régule l’intelligence artificielle (IA) principalement pour encadrer son développement, sa mise sur le marché et son utilisation, afin de minimiser les risques qu’elle peut poser pour la santé, la sécurité et les droits fondamentaux. L’objectif est de promouvoir une IA digne de confiance tout en renforçant la compétitivité de l’UE dans ce domaine.

Il y a également un risque pour la sécurité en particulier dans les transports ou la santé si l’IA n’est pas contrôlée pour minimiser les risques d’accidents et de défaillances.

Coté manipulation de l’information, on sait déjà que L’IA est très utile. En période électorales des IA peuvent massivement manipuler les opinions en diffusant des information plausibles mais fausses.

- Encadrement des systèmes à haut risque : Certains systèmes d’IA présentent un risque plus élevé en raison de leur utilisation ou de leur impact potentiel. Le RIA établit une classification des risques et impose des obligations spécifiques aux systèmes d’IA considérés comme à haut risque. Cela inclut des domaines comme la biométrie, l’emploi, l’éducation, l’accès aux services essentiels, l’application de la loi, la gestion des migrations et l’administration de la justice.

- Maîtrise des modèles d’IA à usage général (GPAI) : Les modèles d’IA à usage général, comme les grands modèles de langage (LLM), ont la capacité de réaliser de nombreuses tâches, ce qui les rend potentiellement plus puissants mais aussi plus risqués. Le RIA encadre ces modèles avec des exigences de transparence, de documentation et d’évaluation des risques systémiques. Les fournisseurs de ces modèles doivent notamment fournir un résumé détaillé des jeux de données d’entraînement, respecter les droits d’auteur et assurer une cybersécurité adéquate.

- Harmonisation du marché européen : La réglementation vise à créer un cadre juridique commun pour l’IA dans l’ensemble de l’Union européenne. Cela permet d’éviter une fragmentation du marché et d’encourager l’innovation tout en assurant un niveau de protection élevé pour les citoyens. Les systèmes d’IA autorisés obtiendront le “marquage CE”.

- Soutien à l’innovation et compétitivité : Bien qu’il s’agisse d’une réglementation, l’AI Act a aussi pour objectif de favoriser l’innovation en définissant un cadre clair et en encourageant les développeurs à intégrer l’IA de manière responsable. Les Testing and Experimentation Facilities for AI (TEF) sont là pour soutenir les PME et les industries dans l’évaluation de leurs systèmes d’IA.

Pourquoi les grandes entreprise critiquent ce règlement

Voici les principales implications de l’IA Act pour les entreprises européennes, d’après les sources :

Principalement en raison des contraintes que cela fait peser sur le développement de solutions d’intelligence artificielles. Les pays concurrents que sont les USA et la Chine et l’Inde ne sont pas soumis à ces règles sur leurs territoires.

Il faut avouer que l’IA fait peur aux consommateurs et que si ils ont le choix ils préfèrent souvent une relation humaine. L’obligation d’informer sur les Chatbot peut freiner leur développement alors que les entreprises veulent les utiliser.

Les entreprise doivent document leur IA génératives. Le risque est d’informer les concurrent sur les solutions en oeuvre. Mais aussi de devoir avouer que leur intelligence est en fait juste un programme IF THEN ELSE pas du tout base sur des technologies d’IA.

L’interdiction de certaines solutions IA par le règlement va totalement stoppé les recherches ne Europe. Alors même que les systèmes de reconnaissance et de profilage ont des applications dans le domaine de la défense et la sécurité. Devrons nous les acheter en Chine avec tous les risques sur nos données ?

Le RIA vous protège-t-il sur le lieu de travail

Beaucoup de salariés peuvent se faire assister dan leur travail par des IA. Cela leur apporte des bénéfices mais peut les mettre aussi en risque.

- Attention particulière aux relations de travail: Le règlement accorde une attention particulière à l’utilisation de l’intelligence artificielle dans le cadre des relations de travail. De nombreux systèmes d’IA sont déjà utilisés pour accomplir des tâches diverses, souvent sous la supervision d’employés assistés par des algorithmes. Cet environnement professionnel est perçu comme étant particulièrement vulnérable aux risques pour la santé, la sécurité, et le respect des droits fondamentaux.

- Le RIA laisse l’initiative aux Etats membres. Le règlement ne crée pas de cadre spécifique pour les relations de travail, sauf exception. Il permet aux États membres d’adopter des mesures législatives ou réglementaires supplémentaires au niveau national pour renforcer la protection des travailleurs face à l’utilisation des systèmes d’IA. Cette approche laisse aux États membres une certaine latitude pour adapter le cadre réglementaire aux particularités de leur législation nationale.

- Réglementation stricte pour les systèmes à haut risque: Les systèmes d’IA à haut risque qui comprennent des cas d’usage spécifiques comme le recrutement ou la gestion des employés, sont soumis à une réglementation stricte. Les employeurs devront informer les représentants des travailleurs avant l’introduction de tels systèmes et veiller à respecter les réglementations en vigueur.

- Contrôle humain effectif: Les systèmes d’IA déployés doivent garantir un contrôle humain effectif, ce qui est particulièrement important dans le domaine de l’emploi, où les décisions prises par l’IA peuvent avoir des conséquences significatives sur la vie des travailleurs. Le recrutement en particulier va être impacté par l’IA. des entreprise font déjà passer les premiers entretiens en vidéo par des IA.

Le cas des IA inacceptables

Comme le règlement l’indique certaines IA sont inacceptables. sauf que des cas sont prévus. C’est ce type de texte qui introduit le loup dans la bergerie et va au final permettre des excès.

Le règlement sur l’IA (AI Act) interdit l’utilisation de certains systèmes d’IA considérés comme présentant un risque inacceptable, mais prévoit des exceptions dans des cas spécifiques.

Voici les principaux points concernant les exceptions aux interdictions des IA inacceptables :

- Motifs de sécurité et d’ordre public:

- Dans le cadre de l’application de la loi, l’identification biométrique à distance en temps réel dans les espaces publics est interdite, sauf dans des situations strictement définies. Ces exceptions comprennent la recherche ciblée de personnes disparues, de victimes d’enlèvement ou de personnes ayant fait l’objet d’un trafic d’êtres humains ou d’une exploitation sexuelle. Cela implique que le système est déjà en place et fonctionne en permanence.

- L’identification est également autorisée pour prévenir une menace spécifique, substantielle et imminente pour la vie ou la sécurité physique, ou une attaque terroriste prévisible. De plus, elle peut être utilisée pour identifier des suspects dans des crimes graves tels que le meurtre, le viol, le vol à main armée, le trafic de stupéfiants et d’armes illégales, le crime organisé et les crimes environnementaux.

- L’utilisation de l’IA dans ces cas doit être justifiée par la nécessité d’éviter un préjudice grave, en tenant compte des droits et libertés des personnes concernées. Avant le déploiement, une évaluation d’impact sur les droits fondamentaux doit être réalisée et le système doit être enregistré dans la base de données de l’UE. Dans les cas d’urgence dûment justifiés, le déploiement peut commencer sans enregistrement préalable, à condition qu’il soit enregistré ultérieurement sans délai indu.

- Conclusion, l’Etat va pouvoir faire comme il voudra, même a postériori

- Autorisation judiciaire ou administrative:

- Avant le déploiement, une autorisation d’une autorité judiciaire ou administrative indépendante est requise. En cas d’urgence justifiée, le déploiement peut commencer sans autorisation préalable, à condition qu’une autorisation soit demandée dans les 24 heures. Si l’autorisation est rejetée, le déploiement doit cesser immédiatement et toutes les données, résultats et sorties doivent être supprimés.

Pourquoi faire un texte si contraignant pour prévoir des mécanismes de contournement si forts ? On terminera sur cette question pour vous laisser réagir.

Sources :

Loi européenne sur l’intelligence artificielle

Ajouter commentaire